Open AI가 지난 2월2일에 새로운 Deep research를 공개했습니다. 벤치마크 테스트에서 Deepseek-R1 보다 정확도가 2.92배 높게 나왔습니다. 프롬프트를 제공하면 수백 개의 온라인 소스를 찾아 분석하여 전문가 수준의 보고서를 생성한다고 하는데, 자세히 알아보겠습니다.

Deep Research는 무엇일까요?

Deep Research는 OpenAI의 최신 o3 모델을 기반으로 만들어 졌고, 웹 브라우징과 데이터 분석에 최적화되어 있습니다. 사용자가 질문을 하면 이 기능은 인터넷 상의 텍스트, 이미지, PDF 파일 등 다양한 자료를 찾아내고, 그 내용을 해석 및 분석하여 체계적인 보고서를 작성합니다. 모든 결과물은 명확한 인용과 사고 과정을 포함해 검증할 수 있도록 제공됩니다.

누구를 위한 서비스인가요?

이 기능은 금융, 과학, 정책, 공학 등 집중적인 지식 작업을 수행하는 전문가뿐만 아니라, 자동차, 가전제품, 가구 등 구매 전 신중한 연구가 필요한 소비자들에게도 큰 도움이 됩니다. Deep Research는 복잡하고 비직관적인 정보를 찾아내어, 사용자가 한 번의 질의로 복잡한 웹 연구를 대신 수행할 수 있도록 도와줍니다.

Deep Research 사용 방법과 작업 과정

ChatGPT 내 메시지 작성 시 ‘deep research’를 선택하고 원하는 질문을 입력하면, 파일이나 스프레드시트를 첨부하여 추가 정보를 제공할 수도 있습니다. 연구 과정은 보통 5분에서 30분 정도 소요되며, 진행 상황은 사이드바를 통해 확인할 수 있습니다. 최종 결과는 보고서 형태로 채팅창에 나타나게 됩니다. 현재는 텍스트 형태로 된 분석 자료만 제공되지만 앞으로는 이미지, 데이터 시각화 등 다양한 분석 자료도 포함될 예정입니다. 현재는 Pro 사용자에게만 제공되며, 곧 Plus, Team, 그리고 Enterprise 사용자에게도 확대될 계획입니다.

기술적 기반과 평가 결과

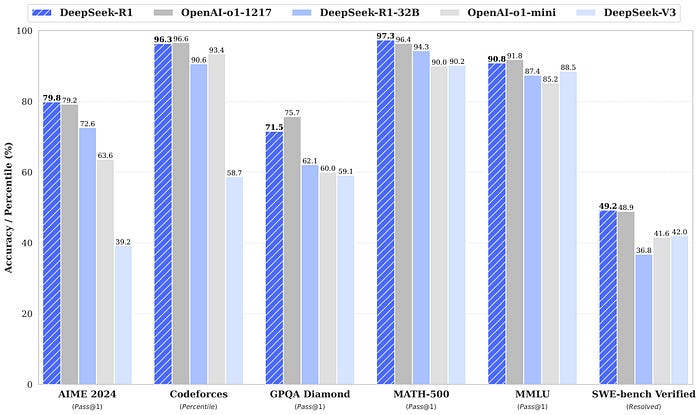

Deep Research는 브라우저와 Python 도구 사용 등 실제 작업에 기반한 강화 학습을 통해 훈련되었습니다. 이로 인해 다양한 도메인에서 뛰어난 성능을 보이고 있습니다

Humanity’s Last Exam

인공지능이 다양한 분야에서 전문가 수준의 문제를 얼마나 잘 풀 수 있는지를 측정하기 위해 만들어진 테스트인데, 평가 결과, OpenAI의 Deep Research 모델이 26.6%의 정확도를 기록하며, 기존 모델들에 비해 크게 향상된 성능을 보였습니다. 특히 화학, 인문사회, 수학 분야에서 큰 성과를 나타냈는데, 이는 이 모델이 필요한 경우 전문 정보를 효과적으로 찾아내는 인간과 유사한 접근 방식을 보였기 때문입니다.

Deep Research의 한계

비록 Deep Research가 혁신적인 기능을 제공하지만, 때때로 사실을 잘못 해석하거나 부정확한 정보를 제공하는 한계도 존재합니다. 초기 버전에서는 보고서 형식이나 인용 방식에 약간의 오류가 발생할 수 있으나, 지속적인 사용과 개선을 통해 이러한 문제는 빠르게 보완될 예정입니다.

향후 발전 방향

향후 Deep Research는 모바일 및 데스크탑 앱에서도 사용 가능해지고, 구독 기반이나 내부 자료와의 연동을 통해 더욱 정교하고 개인화된 연구 결과를 제공할 예정입니다. 또한, 비동기적 온라인 조사와 실제 작업 수행을 결합한 새로운 에이전트 경험을 통해, 사용자의 복잡한 업무를 보다 효과적으로 지원할 것으로 기대됩니다.

Deep Research는 단순한 검색을 넘어, 사용자가 원하는 깊이 있는 연구 결과를 자동으로 제공하는 혁신적 도구로, 앞으로 AI가 지식 창출과 문제 해결에 미치는 영향을 크게 확장시킬 것으로 보입니다.

출처: OpenAI, "Introducing Deep Research" (https://openai.com/index/introducing-deep-research/)

'AI NEWS' 카테고리의 다른 글

| [AI가 만든 대화혁명] 누구나 손안에서 비서 한 명 갖게 되는 시대 (0) | 2025.02.25 |

|---|---|

| [업무가 자동으로 굴러간다] AI가 사무실 풍경을 어떻게 바꿀까? (0) | 2025.02.22 |

| AI 과외 선생님이 학교 수업을 대체할 날이 온다 (0) | 2025.02.13 |

| AI 일자리 전쟁: 2025년 기준, AI가 대체할 직업 vs 새롭게 창출될 직업 (0) | 2025.02.10 |

| 중국 AI의 도전: Deepseek-R1 모델과 수출 규제의 충돌 (0) | 2025.02.02 |